隨著數字化時代的快速發展,大數據技術已成為企業決策與創新的核心驅動力。本文將從大數據技術的基礎概念出發,詳細解析關鍵技術組件,并對主流數據處理服務進行系統比較分析,以幫助讀者在實際應用中做出明智選擇。

一、大數據技術概述

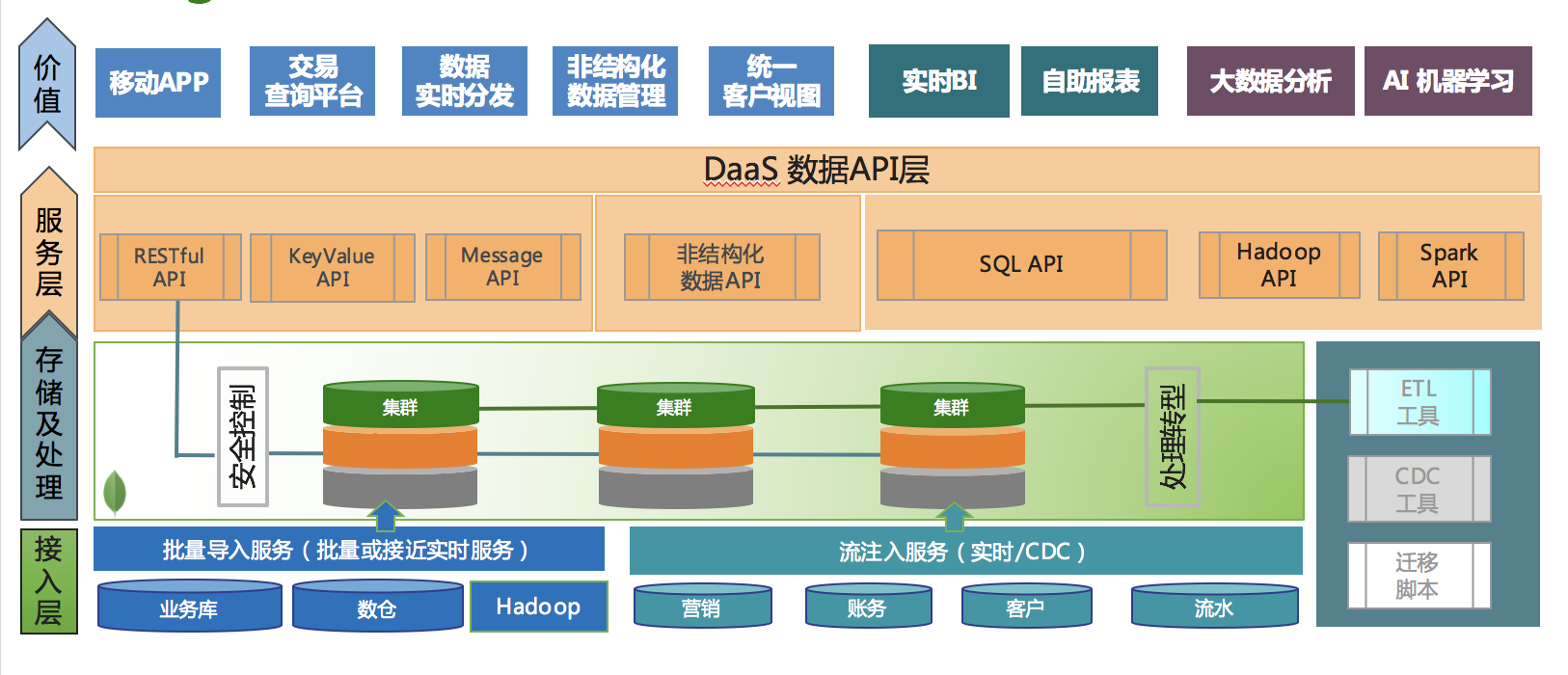

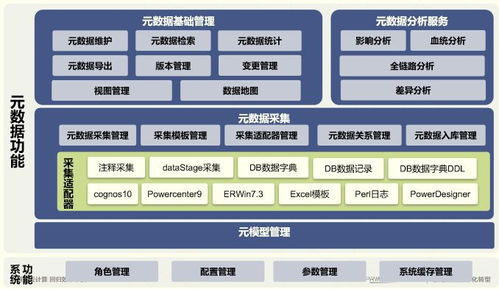

大數據技術是指處理海量、高速、多樣數據的技術集合,其核心特征可歸納為“4V”:Volume(數據量大)、Velocity(數據處理速度快)、Variety(數據類型多樣)和Veracity(數據準確性)。關鍵技術包括數據采集、存儲、處理、分析和可視化等環節。常見的大數據技術框架有Hadoop、Spark、Flink等,它們通過分布式計算和存儲機制,有效解決了傳統數據處理工具的瓶頸問題。

二、關鍵技術詳解

- 數據存儲技術:Hadoop HDFS和NoSQL數據庫(如MongoDB、Cassandra)是大數據存儲的基石。HDFS適合存儲大規模非結構化數據,而NoSQL數據庫則支持靈活的數據模型和高并發訪問。

- 數據處理技術:批處理以Hadoop MapReduce為代表,適用于離線分析;流處理則依賴Spark Streaming或Apache Flink,可實現實時數據流處理。Lambda架構和Kappa架構結合了批處理與流處理的優勢,提升了數據處理的效率與實時性。

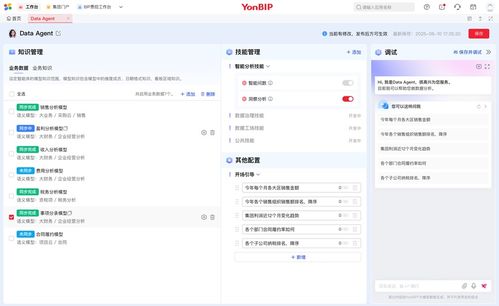

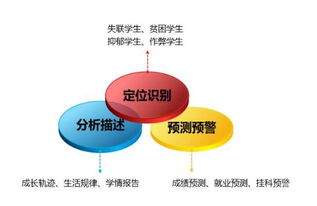

- 數據分析與機器學習:工具如Apache Spark MLlib和TensorFlow支持復雜的數據挖掘和預測建模,幫助企業從數據中提取洞察。

三、數據處理服務比較分析

數據處理服務通常分為本地部署和云服務兩種模式。以下對主流云數據處理服務進行對比:

- Amazon Web Services (AWS):提供全面的數據服務,如Amazon S3用于存儲、Amazon EMR用于處理、Amazon Redshift用于分析。優勢在于生態系統完整、可擴展性強,但成本可能較高。

- Microsoft Azure:Azure Data Lake Storage和Azure Databricks等服務支持大規模數據處理,與微軟產品集成度高,適合企業級應用,但學習曲線較陡。

- Google Cloud Platform (GCP):BigQuery和Dataflow服務以高性能和易用性著稱,特別適合實時分析和機器學習場景,但市場份額相對較小。

- 阿里云:MaxCompute和DataWorks等服務在國內市場占主導,成本較低且符合本地法規,但國際支持有限。

四、選擇建議與應用場景

在選擇數據處理服務時,企業需考慮數據規模、實時性需求、成本預算和技術團隊能力。例如,初創公司可優先選擇GCP以快速部署,而大型企業可能更傾向AWS或Azure的全面解決方案。實際應用中,金融行業常采用實時流處理進行欺詐檢測,電商領域則依賴批處理分析用戶行為。

大數據技術和數據處理服務不斷演進,企業應結合自身需求,靈活選用技術框架與服務提供商,以最大化數據價值。未來,隨著AI與邊緣計算的融合,大數據處理將更加智能化和去中心化。